9月1日消息,美团宣布正式发布LongCat-Flash-Chat AI模型,并同步开源,采用创新性混合专家(MoE),总参数量达560B(5600亿),实际激活参数18.6-31.3B,平均仅27B,从而实现计算效率与性能的双重优化。

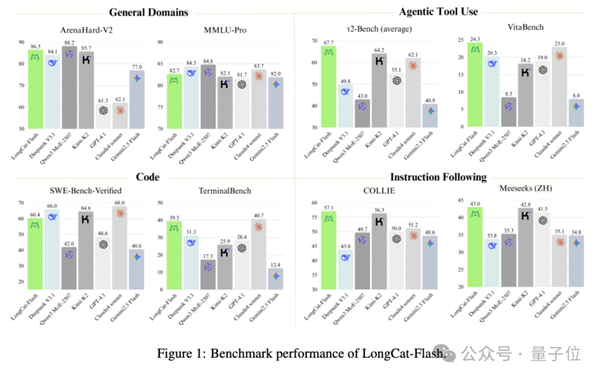

美团声称,根据多项基准测试综合评估,作为一款非思考型基础模型,LongCat-Flash-Chat在仅激活少量参数的前提下,性能就可以比肩当下领先的主流模型,尤其在智能体任务中具备突出优势。

同时,因为面向推理效率的设计和创新,LongCat-Flash-Chat具有明显更快的推理速度,更适合于耗时较长的复杂智能体应用。

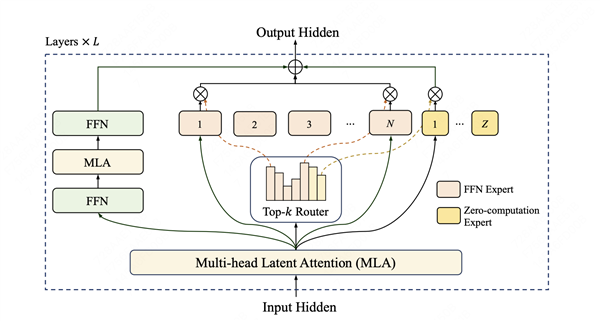

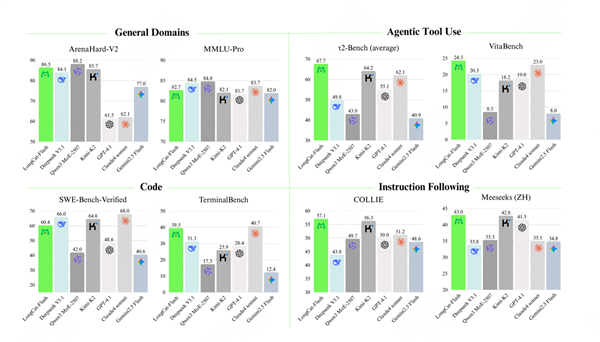

美团LongCat-Flash在架构层面引入“零计算专家(Zero-Computation Experts)”机制,总参数量560B,每token依据上下文需求仅激活18.6-31.3B参数,实现算力按需分配和高效利用。

为控制总算力消耗,训练过程采用PID控制器实时微调专家偏置,将单个token的平均激活量稳定在约27B。

此外,LongCat-Flash在层间铺设跨层通道,使MoE的通信和计算能很大程度上并行,极大提高了训练和推理效率。

配合定制化的底层优化,LongCat-Flash在30天内完成了高效训练,并在H800 GPU上实现单用户100+ tokens/s的推理速度。

LongCat-Flash还对常用大模型组件和训练方式进行了改进,使用了超参迁移和模型层叠加的方式进行训练,并结合了多项策略保证训练稳定性,使得训练全程高效且顺利。

针对智能体(Agentic)能力,LongCat-Flash自建了Agentic评测集指导数据策略,并在训练全流程进行了全面的优化,包括使用多智能体方法生成多样化高质量的轨迹数据等,实现了优异的智能体能力。

通过算法和工程层面的联合设计,LongCat-Flash在理论上的成本和速度都大幅领先行业同等规模、甚至规模更小的模型。

通过系统优化,LongCat-Flash在H800上达成了100 tokens/s的生成速度,同时输出成本低至5元/百万token。

通用领域知识方面,LongCat-Flash在ArenaHard-V2基准测试中取得86.50的优异成绩,位列所有评估模型中的第二名。

在基础基准测试中,MMLU(多任务语言理解基准)得分为89.71,CEval(中文通用能力评估基准)得分为 90.44。

这些成绩可与目前国内领先的模型比肩,且其参数规模少于DeepSeek-V3.1、Kimi-K2等产品。

智能体工具使用方面,LongCat-Flash即便与参数规模更大的模型相比,在τ2-Bench(智能体工具使用基准)中的表现仍超越其他模型;高复杂度场景下,在VitaBench(复杂场景智能体基准)中以24.30分位列第一。

编程方面,LongCat-Flash在TerminalBench(终端命令行任务基准)中,以39.51的得分位列第二,在SWE-Bench-Verified(软件工程师能力验证基准)中得分为 60.4。

指令遵循方面,LongCat-Flash在IFEval(指令遵循评估基准)中以89.65的得分位列第一,在COLLIE(中文指令遵循基准)和 Meeseeks-zh(中文多场景指令基准)中成绩分别为 57.10 和 43.03。

美团同步提供了分别基于SGLang和vLLM的两种高效部署方案。

以下为使用SGLang进行单机部署的示例:

python3 -m sglang.launch_server \

--model meituan-longcat/LongCat-Flash-Chat-FP8 \

--trust-remote-code \

--attention-backend flashinfer \

--enable-ep-moe \

--tp 8

现在前往https://oss.xajjn.com/article/2025/09/01/335.chat ,就能立即与LongCat-Flash-Chat开启对话。

开源平台地址:

Hugging Face:

https://huggingface.co/meituan-longcat/LongCat-Flash-Chat

Github:

https://github.com/meituan-longcat/LongCat-Flash-Chat

开源仓库统一采用MIT License,并允许用户利用模型输出、通过模型蒸馏等方式训练其他模型。

本文转载于快科技,文中观点仅代表作者个人看法,本站只做信息存储

阅读前请先查看【免责声明】本文内容由互联网用户自发贡献,该文观点仅代表作者本人,本站仅供展示。如发现本站有涉嫌抄袭侵权/违法违规的内容,请发送邮件至 1217266901@qq.com 举报,一经查实,本站将立刻删除。 转载请注明出处:https://www.jingfakeji.com/tech/95690.html